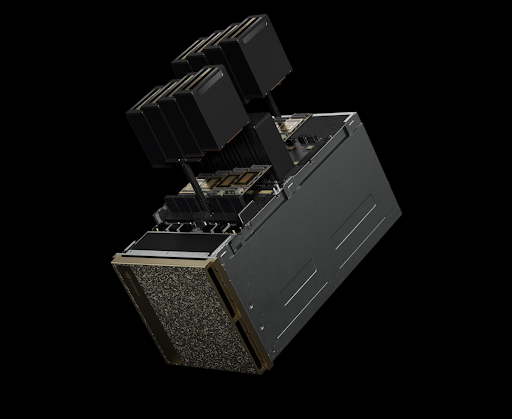

Runyour AI, NVIDIA B200 공급 개시 / 사진. NVIDIA

AI 클라우드 중개 플랫폼 'Runyour AI'가 NVIDIA의 차세대 GPU 'B200'의 공식 공급을 시작했다. 국내 기업과 연구기관은 이를 통해 최신 AI 학습 인프라를 신속하게 확보할 수 있게 됐다.

몬드리안에이아이는 5월 11일(일) NVIDIA Blackwell 아키텍처 기반 GPU인 B200의 국내 공급 개시를 발표하며, AI 학습·추론 환경에서 획기적인 성능 향상을 제공할 것이라고 밝혔다.

공급되는 NVIDIA B200은 AI 워크로드에 최적화된 하드웨어 사양을 갖췄다. 총 2080억 개의 트랜지스터와 듀얼 다이(Dual-Die) 설계를 기반으로 단일 GPU 기준 FP8 연산 성능 20페타플롭스(PFLOPS)를 지원하며, LLM(대규모 언어모델)과 생성형 AI에 필수적인 192㎇의 HBM3e 메모리와 8TB/s 메모리 대역폭을 제공한다. 또한 NVLink 5세대 인터커넥트를 활용해 최대 1.8TB/s에 이르는 GPU 간 초고속 P2P 연결이 가능하다.

몬드리안에이아이는 “B200은 기존 대비 AI 학습과 추론 모두에서 4배 이상의 성능 향상을 제공하는 혁신적 제품”이라며 “Runyour AI 플랫폼을 통해 국내 기업들이 가장 빠르고 효율적인 방식으로 최신 Blackwell 기반 GPU 인프라를 도입할 수 있도록 지원할 것”이라고 밝혔다.

Runyour AI는 GPU 소유자와 수요자를 연결하는 전문 클라우드 중개 플랫폼으로 기업 및 연구기관은 온디맨드 방식 또는 장기 계약을 통해 유연하게 GPU 자원을 활용할 수 있으며, 특히 LLM 학습 및 추론 환경에서 NVIDIA B200의 도입은 최대 30배에 달하는 성능 향상을 기대할 수 있다.

한편, 몬드리안에이아이는 오는 5월 14일(수)부터 16일(금)까지 서울 코엑스에서 열리는 ‘AI EXPO KOREA 2025(국제인공지능대전)’에 참가해 Runyour AI의 GPU 클라우드 서비스를 선보일 예정이다.